Echtzeit style transfer

- Datum: März 2019

- Kategorie: Experimente

- Schlagwörter: #2018 #TouchDesigner #kinect

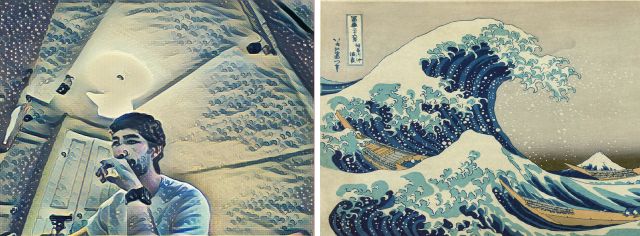

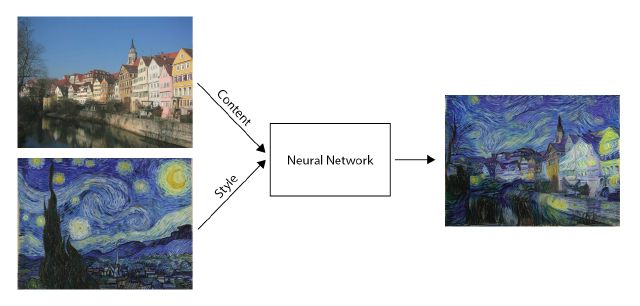

Experimentieren mit einem neuronalen Netzwerk, das in Echtzeit Style Transfer durchführt.

Wie es funktioniert: Ich erfasse das Kinect-Video in Touchdesigner, sende es über Spout an ein Konsolenprogramm, das den Style Transfer durchführt. Das Ergebnis wird mit Spout zurück an Touchdesigner gesendet. Ich wende die von Kinect bereitgestellte Maske auf das Ergebnis an und ändere die Deckkraft dieser Maske mithilfe der Position des Spielers auf dem Bildschirm.

Referenzen: Für den Style Transfer habe ich Neural VJ mit einigen bereits im Netzwerk trainierten Stilen verwendet.

Leistung: Es läuft im Durchschnitt mit 8 fps bei einer Auflösung von 640×480 auf einer Nvidia GeForce GTX 970.

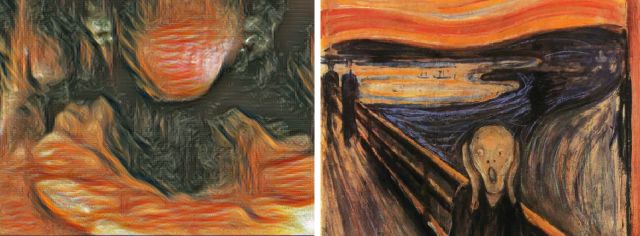

Andere Ergebnisse